Daka-Team rejoint le groupe Ntico !

ANNONCE

Daka-Team rejoint le groupe Ntico !

Une nouvelle aventure commence !

Nous unissons nos forces pour renforcer notre position d’experts dans le domaine de la Data.

Ce partenariat marque une étape clé dans notre développement, porté par une ambition partagée : proposer à nos clients des solutions toujours plus innovantes, efficaces et adaptées aux enjeux technologiques de demain.

Une vision commune, une complémentarité affirmée

Depuis 15 ans, Ntico accompagne les entreprises dans leur transformation numérique, en combinant conseil, data et développement d’applications sur mesure.

De son côté, Daka-Team s’est imposé comme un acteur majeur de la Data et de son écosystème, grâce à une expertise pointue en architecture, urbanisation, industrialisation et sécurisation des données.

Cette intégration au groupe Ntico repose sur une conviction forte : la complémentarité de nos offres et de nos expertises. Elle nous permet de proposer à nos clients une palette de compétences plus large, tout en nous appuyant sur un centre de services data reconnu, performant et complémentaire.

Une aventure humaine, au service de la performance

Au-delà de la stratégie, ce partenariat est avant tout une rencontre humaine, fondée sur des valeurs communes : le partage, l’engagement et la volonté d’innover ensemble.

En réunissant nos équipes, nous faisons le choix d’une dynamique collective : progresser, développer nos compétences et partager nos savoir-faire. Deux équipes qui partagent les mêmes valeurs, la même énergie et l’envie de progresser ensemble !

Ce n’est que le début !

En réunissant nos talents et nos savoir-faire, nous sommes prêts à relever de nouveaux défis plus ambitieux, avec la passion de la Data comme moteur commun !

Bienvenue à l’équipe Daka-Team dans cette belle aventure humaine et technologique !

ROADSHOW 2025

ROADSHOW 2025

Premier roadshow 2025 à Lille !

Le 3 avril dernier avait lieu notre premier Roadshow 2025 et nous avons commencé par Lille ! 🙌

L’occasion de faire un bilan, un an après le début du partenariat avec SMA, pour échanger sur les dernières nouveautés OpCon et réaliser un atelier technique autour de la solution ✅

Les prochaines dates : rendez-vous le 10 avril à Montpellier & le 17 avril à Lyon ! 📣

Vous souhaitez participer à une prochaine rencontre ? Contactez votre interlocuteur dédié Ntico ou commentez ce post : https://www.linkedin.com/feed/update/urn:li:activity:7314889803068567552 ! 🤝

Animation mensuelle : Peinture sur céramique

ANIMATION MENSUELLE

Peinture sur céramique

Chez Ntico, les animations se suivent mais ne se ressemblent pas ! 🙌

Cette fois, nouvelle expérience pour nos #CollabsAuTop qui se sont essayés à la peinture sur céramique ! 🎨🖌️

Talent caché ou patience mise à l’épreuve ? Une chose est sûre : créativité, bonne humeur et partage étaient au rendez-vous ! 🤗

EMOJI STORY - ÉPISODE 3

EMOJI STORY - ÉPISODE 3

Place au troisième épisode de notre série #EmojiStory ! 🚀

Aujourd’hui, découvrez Martin, Chef de Projet chez Ntico ! 👨💻 Entre mythes et anecdotes, il vous partage son quotidien ! 🚀

Pour lui, un Chef de Projet, c’est avant tout de la bonne humeur et une communication au top ! Et ça tombe bien, chez Ntico, on aime travailler dans une ambiance conviviale ! 🤗✨

15 ans Ntico

15 ANS

Joyeux anniversaire Ntico !

🎥 Retour en images sur ces 1️⃣5️⃣ ans, de partage, de progrès et de plaisir !

Merci à tous·tes nos collaborateur·trices, nos clients, nos partenaires de contribuer à cette belle aventure. 🙏

Maintenant, en route pour les 15 prochaines années ! 🚀

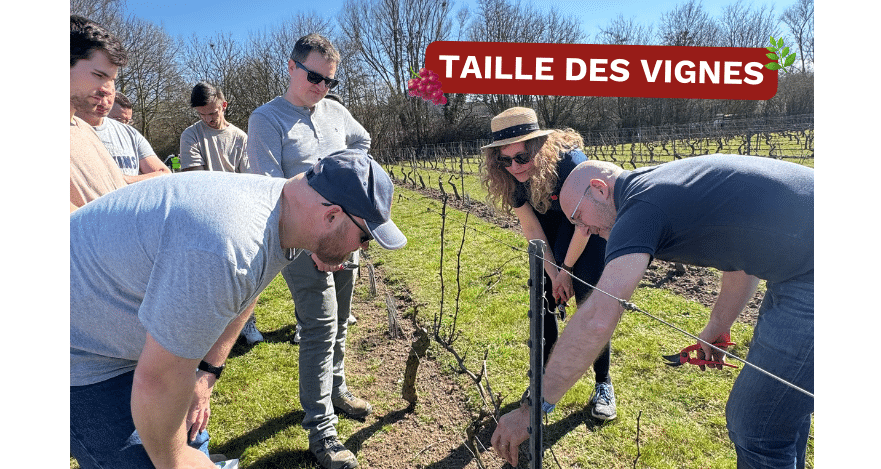

Taille des vignes

TAILLE DES VIGNES

Ntico x APEI de Valenciennes : on continue nos actions concrètes ! 🙌

Quelques mois après l’annonce de notre partenariat avec l’APEI, nos #CollabsAuTop ont troqué leurs claviers pour des sécateurs et se sont initiés à la taille des vignes ! ✂️🍇

👉 Au programme :

– La découverte d’un métier ancestral 🌿

– Une immersion dans le quotidien des travailleurs en situation de handicap 💪

– Un instant hors du bureau (et sous le soleil) ☀️

– De nombreux échanges avec les membres de l’APEI 🤗

Cette activité inédite alliant apprentissage et partage nous a permis de mieux comprendre leur métier, découvrir leur savoir-faire et apprendre à nous adapter ! 🚀

Journée mondiale de la trisomie 21

JOURNÉE MONDIALE DE LA TRISOMIE 21

À nos chaussettes !

Pour valoriser la diversité et la différence, et pour permettre à chacun·e d’agir à son échelle, nos #CollabsAuTop ont porté le 21 mars leurs plus belles chaussettes dépareillées ! 🧦

Fleurs, coeurs, chats, vélos, canard, frites… Peu importe les motifs, le message reste le même : favoriser l’inclusion des personnes en situation de handicap ! 🟡🔵

Grâce à tous les collabs qui ont joué le jeu, un don de 380 € sera reversé à l’association Trisomie 21 France ! 🙌

Certification Qualiopi

CERTIFICATION QUALIOPI

Ntico Opération est certifié Qualiopi !

Une nouvelle étape franchie chez Ntico ! ✅

Nous sommes fiers d’annoncer que Ntico Operation est désormais certifié QUALIOPI ! 🤩

Cette certification atteste de la qualité de nos formations OpCon et de notre engagement à accompagner nos clients avec des solutions conforme aux exigences du marché de l’automatisation ! 💻

Vous souhaitez en savoir plus sur notre parcours de formations OpCon ? C’est juste ici 👉 https://www.ntico.com/organisme-formation/

8 MARS

8 MARS

Journée internationale des droits des femmes

Le 8 mars, c’est la journée internationale des droits des femmes ! 🙌

Mais chez Ntico, c’est tout au long de l’année que l’on s’engage pour la féminisation des métiers du numérique. 👩💻

Notre index d’égalité professionnelle Ntico Services le reflète bien : 93/100 ! 🤩💪

À notre échelle, chaque action compte car il y a encore du chemin à parcourir pour l’égalité ! 🚀

👉 Envie d’en savoir plus sur nos actions ? C’est juste ici : https://lnkd.in/efFf76nC

Animation mensuelle février 2025

ANIMATION MENSUELLE

Nos #CollabsAuTop ont sorti leurs raquettes !

Chez Ntico, février était synonyme d’animations sportives ! 👟💪

Nos#CollabsAuTop ont sorti leurs raquettes pour jouer au badminton, au padel, au ping-pong et au squash, dans toutes nos agences ! 🏸🎾🏓

Au programme : convivialité, échanges et compétition (on est quand même là pour gagner 😎) !

Merci à tous·tes les participant·e·s pour ces moments de partage ! 🙌